Шахматы на поле боя. Как искусственный интеллект меняет военное дело

Искусственный интеллект расширяет наши возможности и способен вытеснить некоторые существующие специализации, освободив людей для более “человечных” видов деятельности. Не обошло это стороной и военных.

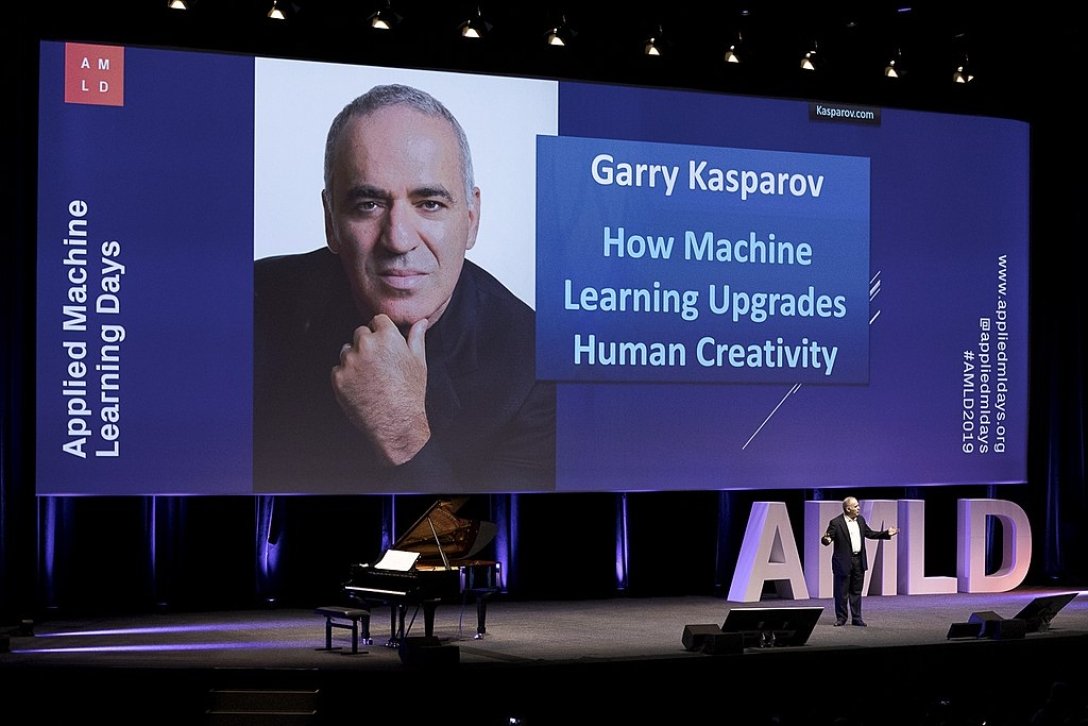

Гарри Каспаров, один из величайших шахматистов всех времен, разработал продвинутые шахматы после того, как в 1997 году проиграл матч суперкомпьютеру Deep Blue компании IBM. В продвинутых шахматах сочетаются вычислительная точность машинных алгоритмов и человеческая интуиция. Эксперименты Каспарова, схожие по концепции со взаимодействием пилотируемых и беспилотных воздушных судов или с “моделью кентавра”, имеют важные последствия для использования ИИ военными.

Перевели новый текст авторов Тревора Филлипс-Левина, Майкла Канаана, Дилана “Джус” Филлипс-Левина, Уокера Д. Миллса и Ноы Спатаро, посвященный искусственному интеллекту на службе у военных.

По закону Каспарова. Как искусственный интеллект создает новые военные специальности

В 2005 году на одном из шахматных сайтов провели турнир по продвинутым шахматам, в котором мог принять участие любой желающий. Весьма неожиданно, что победителями турнира стали не гроссмейстеры и их машины, а два шахматиста-любителя, использующие три разных компьютера.

Гарри Каспаров заметил: “Их умение применять и “тренировать” свои компьютеры, чтобы те досконально изучали позиции, эффективно противостояло превосходным шахматным талантам их оппонентов-гроссмейстеров и большей вычислительной мощности других участников”.

Каспаров заключил, что “слабый человек + машина + лучший процесс превосходит как сильный компьютер в отдельности, так и… сочетание сильного человека + машины + худшего процесса”. Этот вывод известен как закон Каспарова.

Поскольку Министерство обороны стремится повысить эффективность ИИ, закон Каспарова может помочь в разработке архитектуры управления и подготовки военнослужащих, которые будут его использовать.

Закон Каспарова предполагает, что для эффективного взаимодействия человека и машины операторы должны быть знакомы со своими машинами и знать, как лучше их применить. В конфликтах будущего победят не силы, обладающие самой высокой вычислительной мощностью, самой передовой конструкцией микросхем или лучшей тактической подготовкой, а те, которые наиболее успешно используют новые алгоритмы для дополнения процесса принятия решений человеком. Чтобы достичь этого, американским военным необходимо найти, нанять и сохранить людей, не только разбирающихся в данных и машинной логике, но и способных в полной мере их использовать. С учетом этого следует усовершенствовать вступительные экзамены, общую военную подготовку и профессиональное военное образование.

Взаимодействие человека и ЭВМ: оптимизация процесса

Главная идея Каспарова заключалась в том, что для построения “наилучшего процесса” необходим хорошо информированный оператор на интерфейсе взаимодействия между человеком и машиной. Если операторы не понимают правил и ограничений своих ИИ, они будут задавать неправильные вопросы или отдавать неверные команды.

У Каспарова “слабый человек” не означает неумелый или необученный. “Слабый человек” понимает правила компьютера. Два любителя, победившие в шахматном матче 2005 года, использовали свое знание правил, чтобы задавать правильные вопросы правильным образом. Эти любители не были гроссмейстерами или экспертами с продвинутыми стратегиями. Но они смогли расшифровать данные, которые им предоставили компьютеры, чтобы раскрыть планы своих противников и рассчитать правильные ходы. Другими словами, они использовали компьютер в роли специалиста или эксперта, обосновывающего процесс принятия решений.

Количество и типы данных в глобальной сети быстро растут. Как и в шахматах, алгоритмы могут просеивать, сортировать и структурировать данные разведки, чтобы человеку было легче их интерпретировать.

Алгоритмы ИИ могут находить закономерности и вероятности, в то время как люди определяют их контекстуальное значение для разработки стратегии. Важнейший вопрос заключается в том, как эффективнее всего организовать и обучить таких людей.

Как использовать ИИ в военных целях. Знакомство и доверие

Когда люди-операторы плохо знакомы с системами ИИ, они часто испытывают либо слишком малое, либо необоснованно большое доверие к ним. Чтобы научить военных операторов правильно использовать ИИ, необходимо ознакомить их с ограничениями систем и привить им необходимый уровень доверия. Это особенно важно в критических ситуациях, когда человек-оператор может решить отключить или отменить решение ИИ. Уровень доверия к ИИ зависит от зрелости и доказанной эффективности системы. Пока системы ИИ находятся на стадии разработки или тестирования, операторы-люди должны быть хорошо осведомлены об ограничениях и поведении машины, чтобы управлять ею в случае необходимости. Но все меняется по мере роста надежности ИИ.

Рассмотрим внедрение автоматической системы предотвращения столкновений с землей (auto-GCAS) на истребителях F-16. Внедрение системы затянулось из-за назойливых сигналов “штурвал на себя”, когда ИИ без необходимости брал на себя управление полетом во время ранних летных испытаний и эксплуатации. Недоверие, которое это вызвало у летчиков, было вполне объяснимо. По мере распространения такой информации в сообществе F-16 многие летчики стали полностью отключать систему. Но со временем технология становилась все более надежной, а недоверие само по себе стало проблемой, не позволяя летчикам использовать преимущества проверенного алгоритма спасения жизни. Теперь летчики-новички гораздо больше доверяют системе.

Лейтенант Дэвид Алман, летчик Национальной гвардии ВВС, проходящий летную подготовку на F-16, сказал авторам статьи: “Я думаю, что средний курсант курса “В” очень доверяет этой системе [auto-GCAS]”. Другими словами, как только система будет доработана, отпадет необходимость столь же тщательно обучать будущих летчиков нюансам поведения своей машины и учить их доверию системе.

Потребовалось несколько политических процедур и кадровых перестановок, прежде чем летчики F-16 начали совершать большинство вылетов с включенной auto-GCAS. Сегодня Агентство перспективных оборонных проектов и ВВС США пытаются автоматизировать некоторые элементы воздушного боя в рамках программы Air Combat Evolution. В рамках программы оценивается доверие летчиков к ИИ, работающим с ними в команде. Было обнаружено, что один из летчиков предвзято относился к системе и отключал помощника ИИ до того, как тот успевал выполнить свою работу. Такое поведение сводит на нет преимущества алгоритмов ИИ. Программы переподготовки могут исправить ситуацию, но если человек-оператор продолжает без причины вмешиваться в работу систем ИИ, военные должны быть готовы отстранить его от участия в процессах, содержащих взаимодействие с ИИ.

В то же время излишняя уверенность в ИИ также может стать проблемой.

“Предвзятое отношение” или чрезмерное доверие к автоматизации возникает, когда пользователи не знают о пределах возможностей своего ИИ. Например, при крушении самолета Air France 447 пилоты страдали от когнитивного диссонанса после того, как автопилот отключился во время грозы. Они не поняли, что дроссели двигателей, физическое положение которых не имеет значения при включенном автопилоте, были установлены на холостом ходу. Потянув на себя стики управления, пилоты ожидали, что двигатели увеличат обороты, как это происходит при нормальном управлении дросселями автопилота. Вместо этого двигатели медленно остановились, и скорость самолета уменьшилась. Несколько минут спустя самолет Air France 447 упал в Атлантику, полностью заглохнув.

Кадры и их таланты

Соответствующая подготовка людей-операторов требует не только определенной зрелости системы, но и разграничения между тактическими и стратегическими формами ИИ. В тактических применениях, таких как самолеты или системы противоракетной обороны, временные рамки могут быть ограничены сверх времени реакции человека, что вынуждает его полностью довериться системе и позволить ей действовать автономно. В стратегических или оперативных ситуациях, напротив, ИИ пытается определить намерения противника, которые охватывают более широкие временные рамки и более неоднозначные данные. Таким образом, аналитики, полагающиеся на результаты работы ИИ, должны быть знакомы с его внутренними механизмами, чтобы воспользоваться преимуществами его превосходных возможностей по обработке данных и поиску закономерностей.

Рассмотрим тактическое применение ИИ в воздушном бою. Например, беспилотники могут работать в полуавтономном или полностью автономном режимах. В таких условиях люди-операторы должны проявлять сдержанность в управлении (так называемое намеренное пренебрежение) чтобы позволить своим ведомым ИИ функционировать без помех.

В пилотируемых самолетах программы-помощники ИИ могут предоставлять летчику пошаговые инструкции для предотвращения приближающейся угрозы, и это совсем не похоже на пошаговые инструкции для водителей автомобилей в приложении Waze. Датчики вокруг истребителя обнаруживают инфракрасные, оптические и электромагнитные сигнатуры, вычисляют направление и режим наведения угрозы и советуют летчику оптимальный набор действий. В некоторых случаях ИИ-пилот может даже взять управление самолетом на себя, если время реакции человека слишком мало, как в случае с автоматическими системами предотвращения столкновения с землей. Когда времени мало, а тип соответствующих данных узок, операторам-людям не нужно быть досконально знакомыми с поведением системы, особенно уже проверенной и сертифицированной. Нет времени сомневаться в поведении ИИ – достаточно знать его возможности и доверять им.

Но вскоре требования изменятся, ведь ИИ постепенно начинает играть все большую роль в стратегических процессах, таких как сбор и анализ разведывательных данных. Когда ИИ используется для агрегирования более широкого спектра на первый взгляд разрозненных данных, понимание его подхода имеет решающее значение для оценки результатов.

Возьмем для примера следующий сценарий: система мониторинга ИИ сканирует сотни бюллетеней по техническому обслуживанию нефтеперерабатывающих заводов и замечает, что несколько государственных нефтяных компаний во враждебной стране объявляют о планах по закрытию своих заводов на “плановое техническое обслуживание” в определенный период. После этого, просмотрев тысячи грузовых деклараций, система обнаруживает, что несколько танкеров, отправляющихся из этой страны, столкнулись с задержками при погрузке своего груза. Затем ИИ сообщает, что данная страна создает условия для экономического шантажа.

На данном этапе человеческий аналитик мог бы лучше оценить этот вывод, если бы знал, какие виды задержек выявила система, насколько они необычны и существуют ли другие политические или экологические факторы, которые могли бы объяснить задержки.

Следующие шаги. Как более эффективно использовать потенциал ИИ для боевых действий

В случае с необученными операторами эффективность ИИ могут свести на нет те самые люди, которым они призваны помочь. Чтобы избежать этого, для ведения боевых действий на основе алгоритмов следует обновить методы отбора и назначения военных кадров.

Панель отборочных авиационных тестов ВМС, офицерский квалификационный тест ВВС или универсальная панель профессиональных способностей вооруженных сил США оценивают успешность кандидата по целому ряду предметов. Поскольку машины уже внедрены в некоторые отрасли знаний, военным необходимо проверять и новые навыки – в частности, способность понимать машинные системы, процессы и программирование.

Изменение вступительных экзаменов с целью проверки навыков интерпретации данных и способности понимать машинную логику стало бы важным первым шагом. Сертификация разработчиков Google или веб-сервисов Amazon предлагают интересные модели, которые военные могли бы адаптировать в своих целях. Армии также стоит поощрять призывников и военнослужащих за прохождение обучения в смежных областях на уже доступных площадках, таких как открытые онлайн-курсы.

Что касается действующих военнослужащих, министр обороны должен способствовать развитию у них соответствующих навыков путем приоритетного конкурсного отбора на курсы, специализирующиеся на изучении систем ИИ.

Среди таких курсов – программа Стэнфордского университета по изучению символьных систем, курс “AI Accelerator” Массачусетского технологического института и курс “Harnessing AI” Высшей военно-морской школы. Военные также могут разработать новые программы на базе таких учебных заведений, как Военно-морской общественный колледж или Высшая военно-морская школа, и наладить партнерские отношения с гражданскими учебными заведениями, которые уже предлагают высококачественное образование в области ИИ.

Целесообразно также включить грамотность в области ИИ в курсы профессионального военного образования и поощрять прохождение факультативных программ по ИИ. Инициатива ВВС по изучению языков программирования, которая теперь отражена в разделе 241 Закона о полномочиях в области национальной обороны на 2021 год, представляет собой важный первый шаг. Все ведомства должны прилагать максимум усилий, предлагая разумные возможности профессионального обучения на всех этапах карьеры военнослужащего.

Искусственный интеллект быстро становится фактором, расширяющим возможности людей, позволяя им сосредоточиться на организации работы, а не на выполнении мелких и повторяющихся задач.

ИИ вполне способен вытеснить некоторые существующие специализации, освободив людей для более “человечных” видов деятельности. Закон Каспарова может помочь военным воспитать ценные кадры, чтобы в полной мере воспользоваться преимуществами этого изменения.

Об авторах

Тревор Филлипс-Левин – военно-морской летчик и офицер отделения объединенной ближней авиационной поддержки ВМС. Соавтор нескольких статей об автономных или дистанционно пилотируемых платформах, опубликованных Центром международной морской безопасности, журналом U.S. Naval Institute Proceedings и Modern Warfare Institute.

Майкл Канаан – научный сотрудник начальника штаба ВВС США в Гарвардской школе Кеннеди. Автор книги T-Minus AI: Humanity’s Countdown to Artificial Intelligence and the New Pursuit of Global Power.

Дилан Филлипс-Левин – военно-морской летчик и старший редактор Центра международной морской безопасности.

Уокер Д. Миллс – офицер морской пехоты, в настоящее время служит по обмену в Колумбийской военно-морской академии в Картахене, Колумбия. Внештатный сотрудник Центра инноваций и современной войны имени Брута Крулака и Инициативы по изучению неконвенциональных боевых действий. Автор многочисленных статей для таких изданий, как War on the Rocks, Proceedings и Marine Corps Gazette.

Ноа “Спул” Спатаро – начальник отдела, занимающийся оценками объединенного всеохватывающего командования и управления в Объединенном комитете начальников штабов. Его опыт работы включает в себя переход на технологии двойного назначения и их спецификации, создание и командование эскадрильей дистанционно пилотируемых самолетов, а также командование и управление авиацией. Закончил с отличием Колледж информации и киберпространства Национального университета обороны.